Windows10+CUDA+cuDNN+TensorRT+TensorRT-YOLO 部署高性能 YOLO11 推理

概述

本指南将带您完成在 Windows 10 环境下构建高性能 YOLO11 目标检测推理系统的完整流程。通过 CUDA、cuDNN、TensorRT 和 TensorRT-YOLO 的组合,您将获得比传统 CPU 推理快 10-100 倍的性能提升,实现真正的实时目标检测应用。

这套技术栈特别适合以下应用场景:

- 实时视频监控:安防系统、智能交通监控

- 自动驾驶:车辆、行人、交通标志检测

- 工业检测:产品质量检测、缺陷识别

- 医疗影像:病灶检测、细胞分析

- 机器人视觉:物体识别、导航辅助

技术架构概览

环境依赖关系

依赖关系说明:

这个依赖关系图展示了从底层硬件到应用层的完整技术栈。每一层都有其特定的作用:

- 硬件层:NVIDIA GPU 提供并行计算能力,是整个加速系统的基础

- 驱动层:NVIDIA 驱动程序负责硬件抽象,提供 CUDA 运行时支持

- 计算平台层:CUDA 提供并行计算框架,cuDNN 提供深度学习算法优化

- 深度学习框架层:PyTorch 提供模型训练和基础推理,TensorRT 提供高性能推理优化

- 应用层:TensorRT-YOLO 提供 YOLO 模型的专业优化,最终实现 YOLO11 的高性能推理

性能优化架构

优化原理说明:

TensorRT 的优化是一个多层次的复杂过程,主要包含以下几个关键步骤:

- 层融合(Layer Fusion):将多个连续的操作合并为单个 GPU 内核,减少内存访问和内核启动开销

- 精度优化:通过 FP16 或 INT8 量化,在保持精度的同时显著提升推理速度

- 内存优化:智能管理 GPU 内存分配,减少内存碎片和分配开销

- 并行优化:充分利用 GPU 的并行计算能力,优化内核调度和执行

这些优化技术的组合使用,能够将 YOLO11 的推理速度提升 3-10 倍,同时减少 50% 的内存使用,实现真正的实时推理性能。

系统要求

软件要求

| 组件 | 版本要求 | 说明 |

|---|---|---|

| 操作系统 | Windows 10 64 位 | 支持最新的 CUDA 和驱动 |

| Python | 3.8-3.14 | 推荐使用 3.12 |

| Visual Studio | 2019/2022 | 用于编译 C++ 代码 |

详细安装步骤

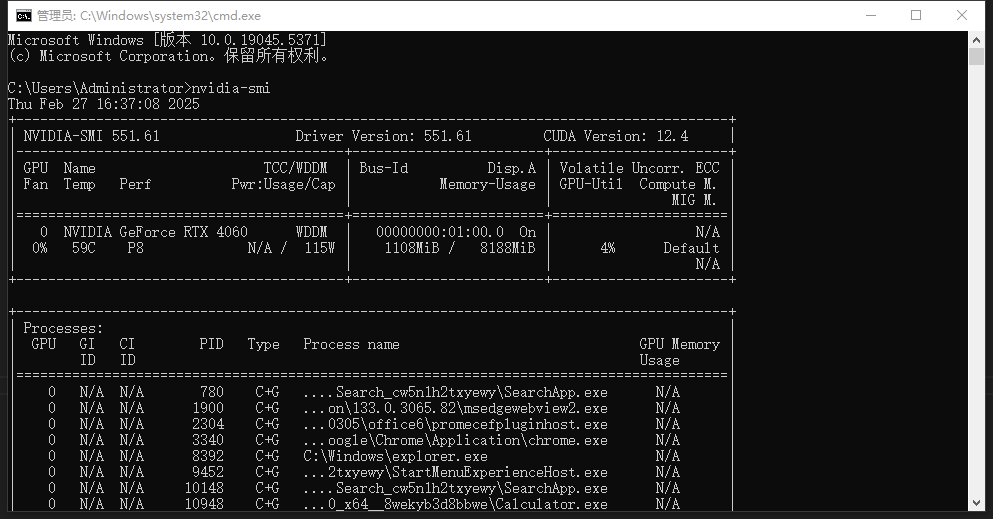

第一步:检查 GPU 信息

在开始安装之前,我们需要确认您的 GPU 是否支持 CUDA 加速。

检查命令:

nvidia-smi

关键信息解读:

| 信息项 | 说明 | 重要性 |

|---|---|---|

| GPU 型号 | 决定 CUDA 支持版本和计算能力 | 影响最终性能 |

| 驱动版本 | 必须与 CUDA 版本兼容 | 版本不匹配会导致安装失败 |

| CUDA 版本 | 显示当前支持的 CUDA 版本 | 决定可安装的 TensorRT 版本 |

| 显存大小 | 影响可加载的模型大小 | 大模型需要更多显存 |

常见问题解决:

- 如果显示 "NVIDIA-SMI has failed",请更新显卡驱动

- 如果 CUDA 版本过低,建议升级到最新版本

- 显存不足 6GB 的 GPU 可能无法运行大型 YOLO 模型

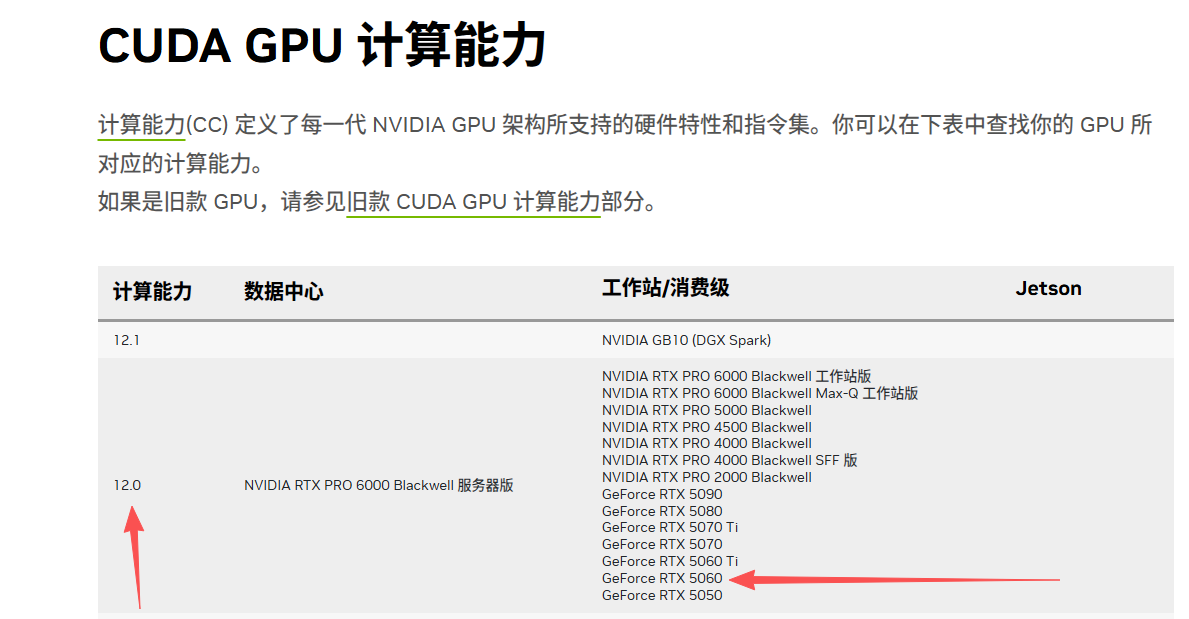

查看显卡计算能力

- 查看地址:CUDA GPU 计算能力

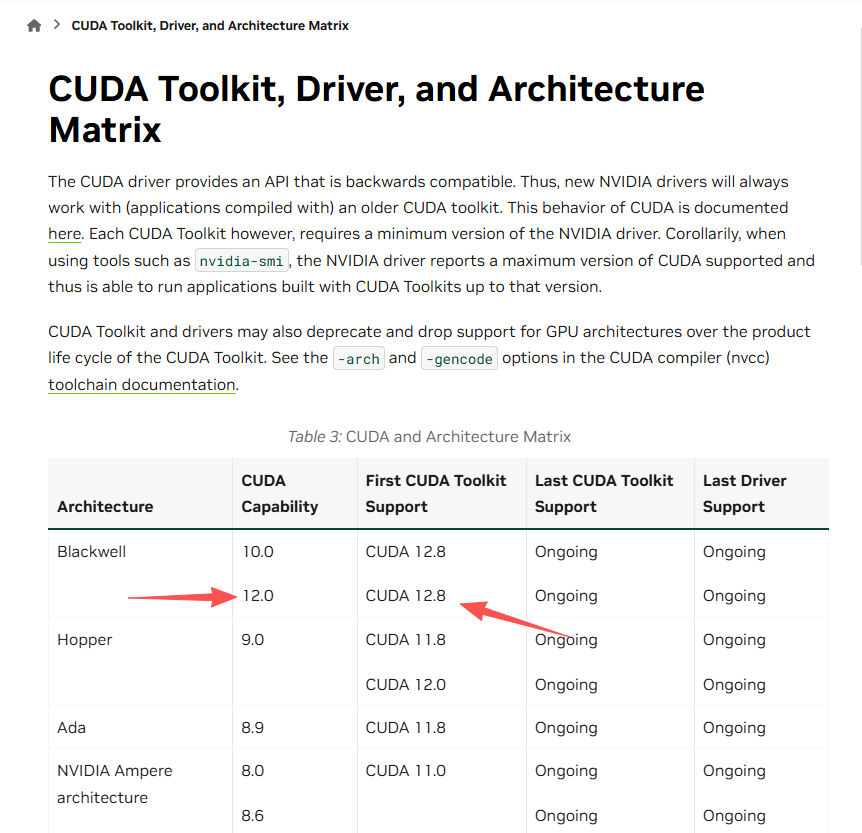

- 查看支持12.0计算能力的CUDA

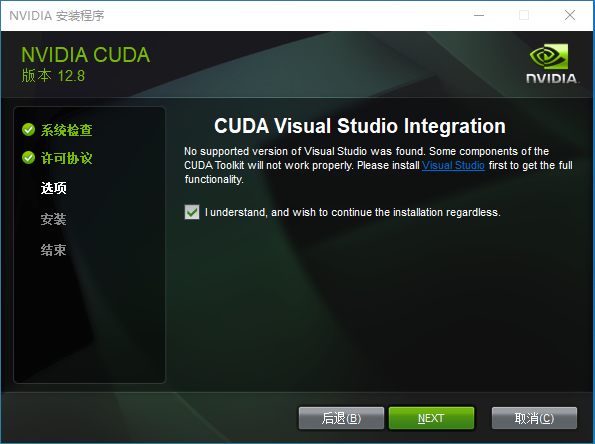

第二步:安装 CUDA Toolkit

CUDA Toolkit 是整个加速系统的基础,提供 GPU 并行计算能力。

下载地址: NVIDIA CUDA Toolkit

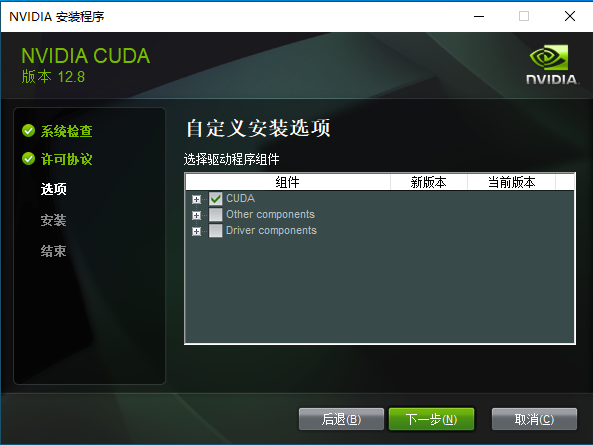

安装要点:

- 版本选择:12.8

- 安装方式:选择"自定义安装",避免覆盖现有驱动

- 路径设置:使用默认安装路径,便于后续配置

- 组件选择:首次安装建议全选,后续安装只选择 CUDA Toolkit

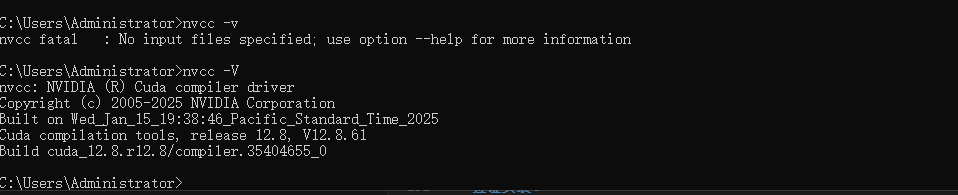

验证安装:

nvcc -V

成功安装后应该显示 CUDA 版本信息。

第三步:安装 visual studio2022

第四步:安装 cuDNN

cuDNN 是 NVIDIA 专门为深度学习优化的库,提供高效的卷积、池化等操作。

下载地址: NVIDIA cuDNN

安装步骤:

- 版本匹配:选择与 CUDA 版本对应的 cuDNN 版本

- 文件解压:解压下载的压缩包

- 文件复制:将 bin、include、lib 文件夹复制到 CUDA 安装目录

- 环境验证:运行

deviceQuery.exe验证安装

关键路径:

- CUDA 安装目录:

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.8 - 需要复制的文件夹:bin、include、lib

第五步:安装 Anaconda

Anaconda 提供 Python 环境管理,确保依赖包的版本兼容性。

下载地址: Anaconda 官网

安装配置:

- 安装选项:勾选"Add Anaconda to PATH"和"Register as default Python"

- 环境创建:创建专门的深度学习环境

conda create --name an_yolo python=3.12

conda activate an_yolo

环境管理优势:

- 隔离不同项目的依赖

- 避免版本冲突

- 便于环境备份和恢复

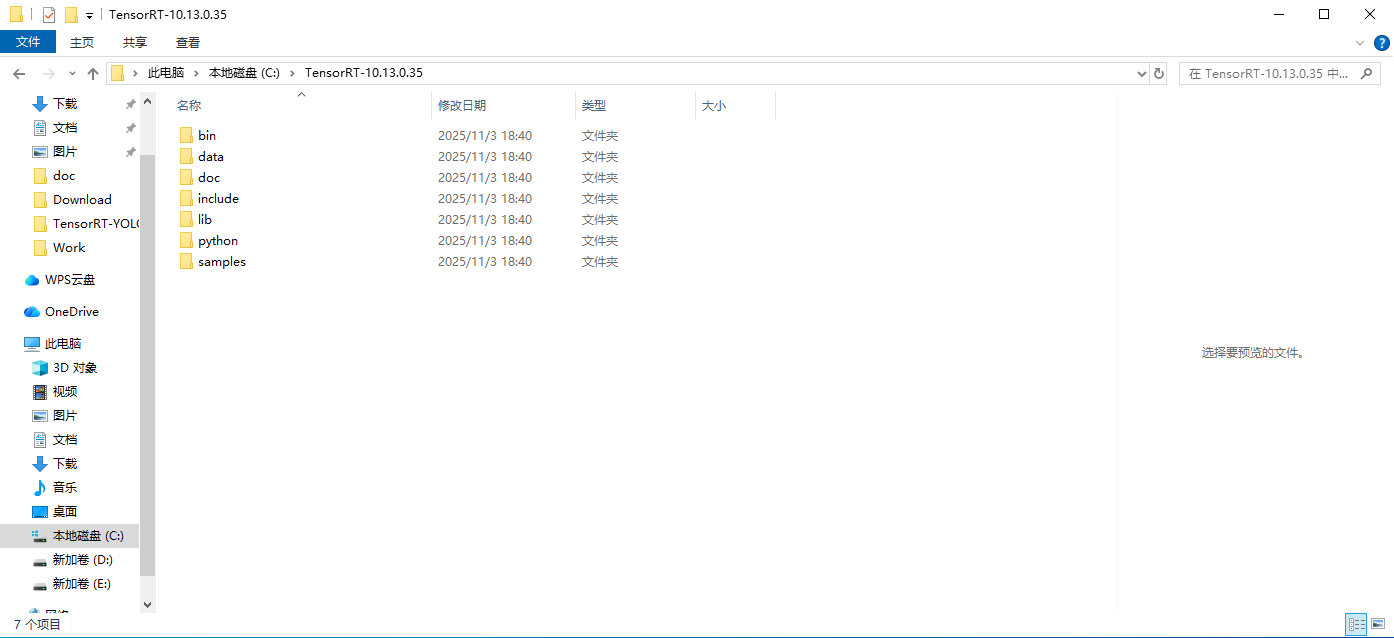

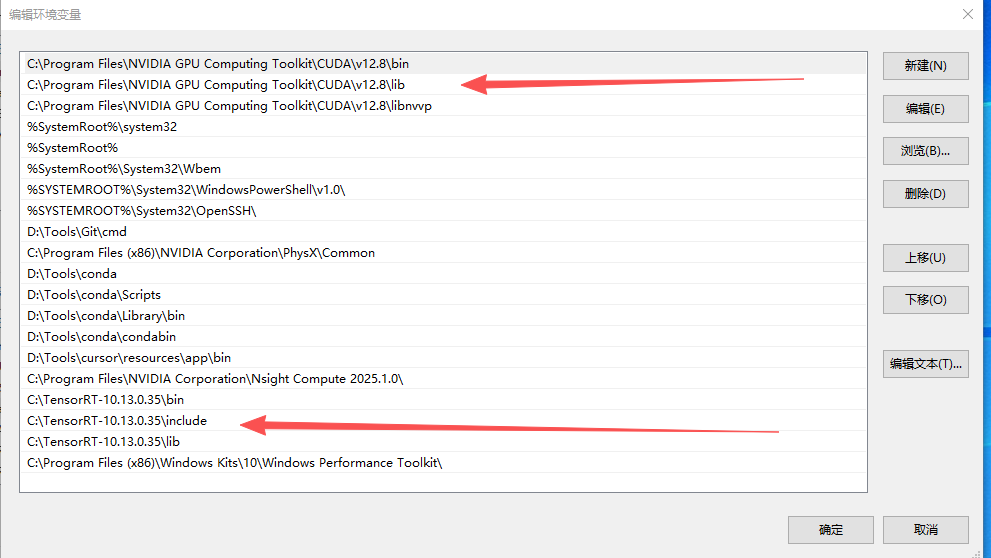

第六步:安装 TensorRT

TensorRT 是 NVIDIA 的推理优化库,提供模型加速和优化功能。

安装步骤:

版本选择:TensorRT 10.13与 CUDA 12.8完全兼容

- 下载地址: NVIDIA TensorRT

文件解压:解压下载的 TensorRT 压缩包

- 环境配置:将 bin、include、lib 文件复制配置到系统变量中

- Python 包安装:

pip install tensorrt-10.1.0-cp310-none-win_amd64.whl

验证安装:

trtexec --help

python -c "import tensorrt; print(tensorrt.__version__)"

第七步:编译 TensorRT-YOLO(6.3.2版本)

TensorRT-YOLO 是专门为 YOLO 模型优化的推理框架。

编译步骤:

- 克隆仓库:

git clone https://github.com/laugh12321/TensorRT-YOLO.git

cd TensorRT-YOLO

- 安装依赖:

pip install CMake

pip install "pybind11[global]"

- CMake配置(set(Python_EXECUTABLE "D:/Tools/conda/envs/an_yolo/python.exe"))

# Python 绑定选项

option(BUILD_PYTHON "Build Python bindings with pybind11" OFF)

if(BUILD_PYTHON)

set(PYBIND11_FINDPYTHON ON)

set(Python_EXECUTABLE "D:/Tools/conda/envs/an_yolo/python.exe")

find_package(Python COMPONENTS Interpreter Development REQUIRED)

find_package(pybind11 CONFIG REQUIRED QUIET)

if(NOT pybind11_FOUND)

message(WARNING "pybind11 not found. Python bindings will not be built.")

set(BUILD_PYTHON OFF)

endif()

endif()

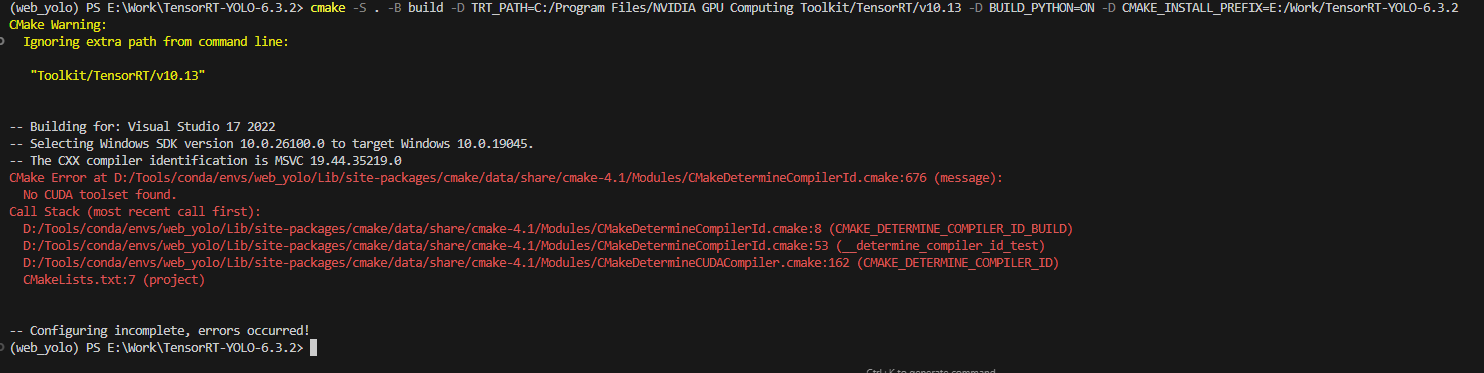

- 配置编译:

cmake -S . -B build -D TRT_PATH=C:/TensorRT-10.13.0.35 -D BUILD_PYTHON=ON -D CMAKE_INSTALL_PREFIX=E:/Work/TensorRT-YOLO-6.3.2

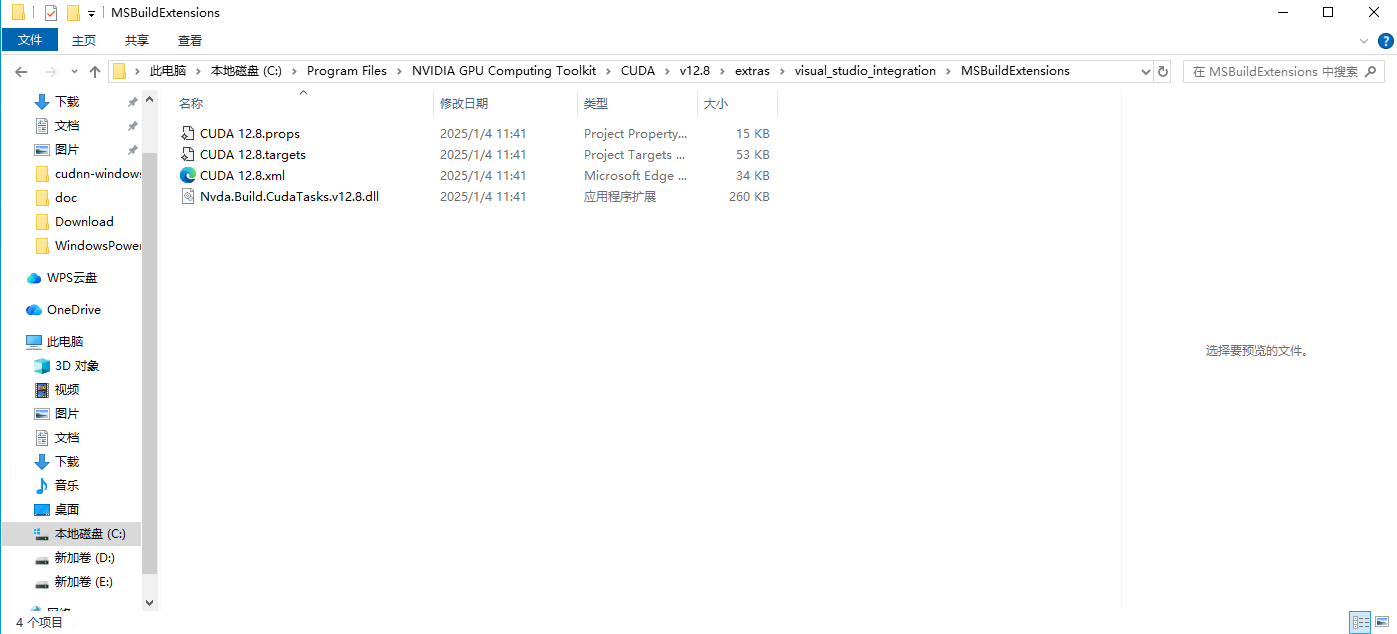

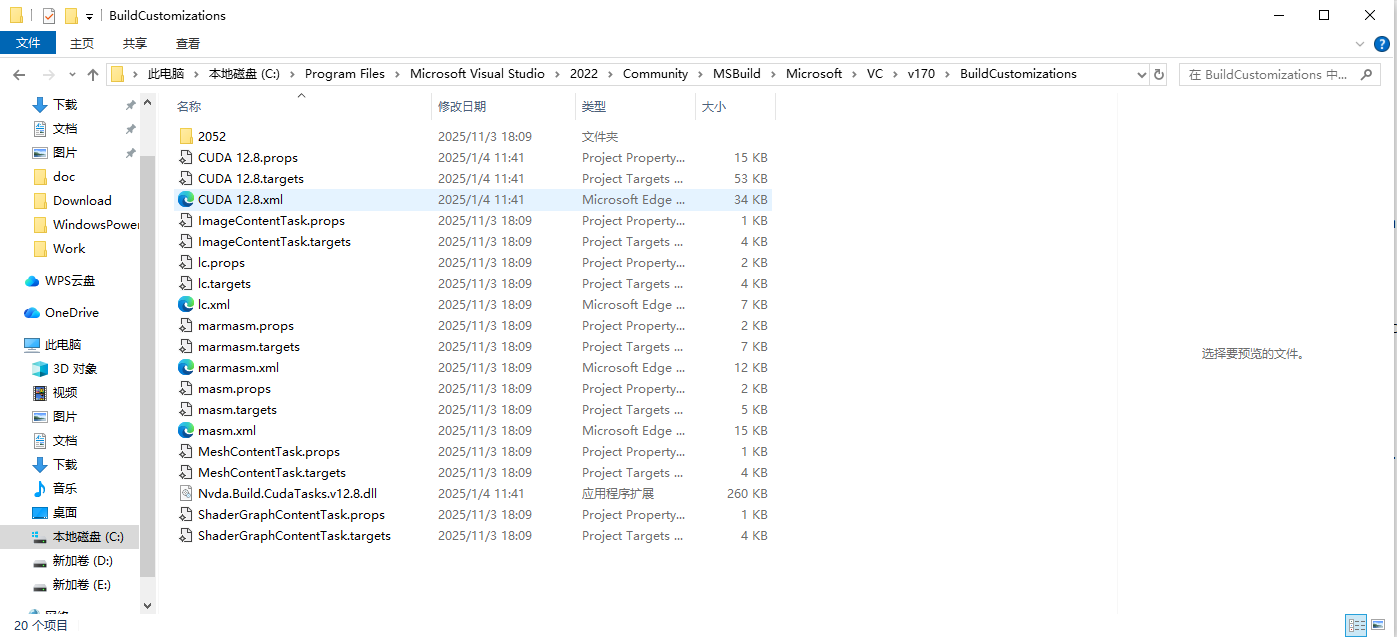

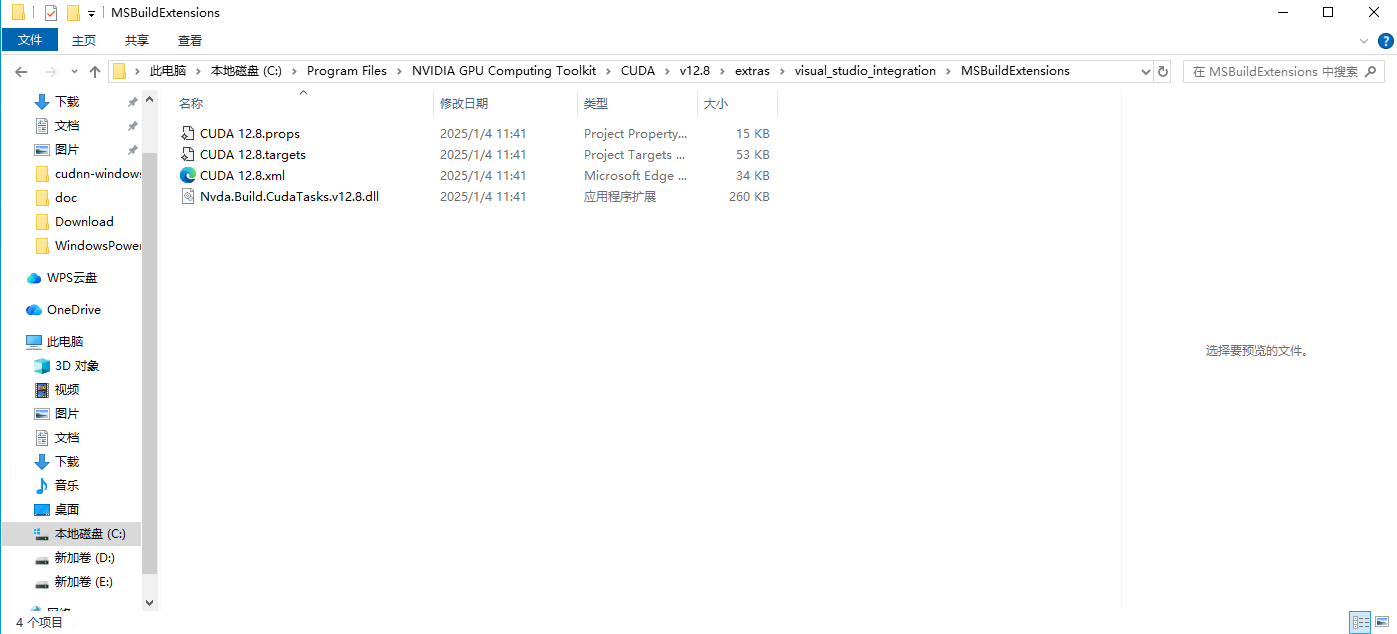

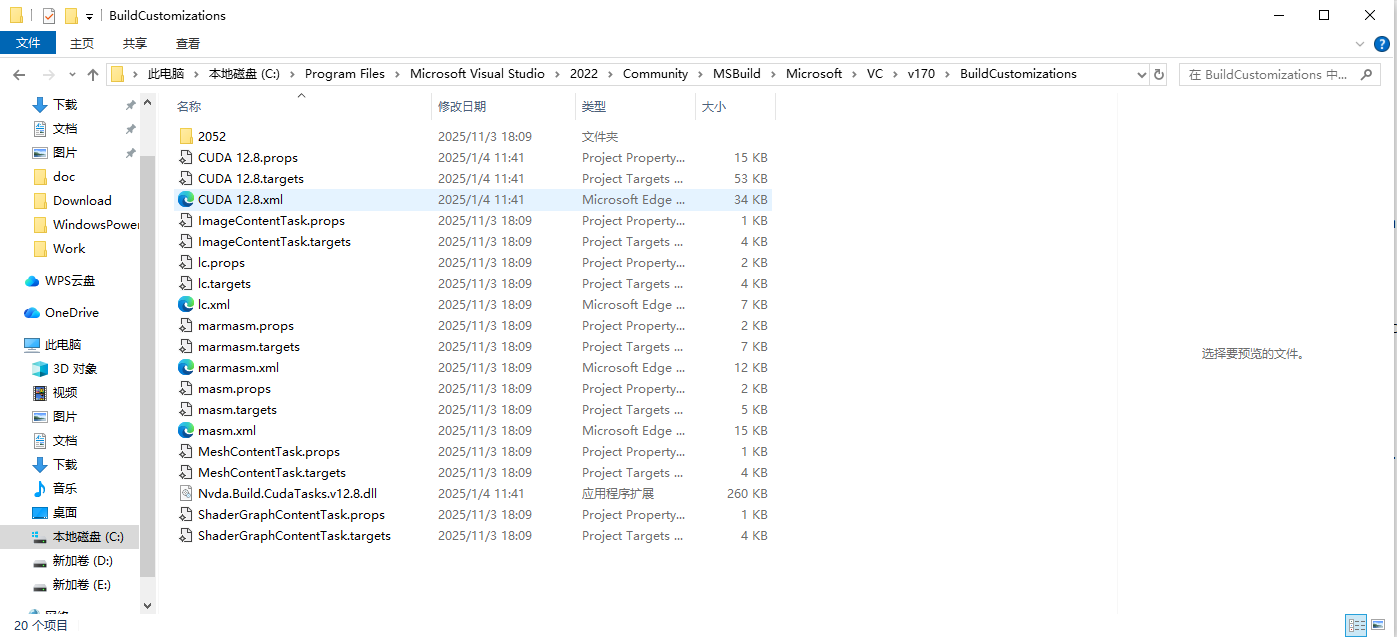

编译时CUDA 工具集未找到:将 CUDA 文件复制到 Visual Studio 目录

最好不要像图中安装在带有空格的文件夹内

- 执行编译:

cmake --build build -j8 --config Release --target install

- 安装 Python 包:

pip install --upgrade build

python -m build --wheel

pip install dist/tensorrt_yolo-6.*-py3-none-any.whl

常见问题解决:

编译时CUDA 工具集未找到:将 CUDA 文件复制到 Visual Studio 目录

CMake 版本过高:降级到 CMake 3.24.0

Visual Studio 版本问题:有时候

总结

通过本指南,您已经成功搭建了一个高性能的 YOLO11 推理环境。这套技术栈的优势在于:

- 性能卓越:相比 CPU 推理提升 10-100 倍性能

- 实时性强:支持 30+ FPS 的实时视频处理

- 精度保持:在加速的同时保持高检测精度

- 易于部署:提供完整的端到端解决方案

- 扩展性强:支持多种 YOLO 模型版本和自定义模型

这套环境特别适合需要实时目标检测的应用场景,如自动驾驶、安防监控、工业检测等。通过合理的优化配置,您可以根据具体需求在性能和精度之间找到最佳平衡点。

下一步建议:

- 尝试不同的模型精度设置,找到最适合您应用的配置

- 进行压力测试,验证系统在高负载下的稳定性

- 考虑部署到生产环境,实现真正的业务价值

- 持续关注 TensorRT 和 YOLO 的更新,保持技术栈的先进性